Generative AI – Fluch oder Segen für Fotografen?

Seit Anfang des Jahres habe ich mich intensiv mit KI-Bildgenerationstools und Animationssoftware auseinandergesetzt. Darunter Midjourney, Runway, Pixa Labs und Stable Diffusion. Über die Monate lernte ich die grossen Möglichkeiten kennen, die die generative AI eröffnet. Gleichzeitig führten manche technische Limitationen der Software zu Frustration.

Dieser Beitrag soll nicht als Tutorial dienen, wie man den perfekten Prompt erstellt, auch nicht als Sozialkritik oder als medienethische Analyse. Dazu gerne in einem späteren Beitrag. Die aktuelle Episode soll meine pragmatischen Gedanken aufzeigen, wie die Zukunft der Fotografie aussehen könnte.

Ein Querschnitt meiner Arbeiten mit Midjourney. Dank der KI-Software kann vergleichsweise einfach ein Charakter erstellt werden, den man vom Äusseren beliebig anpassen kann. Mittels verschiedener Parameter lassen sich auch die Lichtquelle, die Farbtemperatur, Kamera, Objektiv und vieles weiteres anpassen. Auch der Stil kann festgelegt werden – von Realismus über Cartoon bis hin zu Futurismus ist alles möglich. Der Fantasie sind dabei kaum Grenzen gesetzt.

Kein Mensch, keine Rechte

Im obigen Bild wird eine Medizinische Praxisassistentin und eine Yogalehrerin an ihrem Arbeitsplatz gezeigt. Da die Personen nicht wirklich existieren, haben sie auch kein Recht am eigenen Bild und keinen digitalen Fussabdruck. Auf Knopfdruck lassen sich der Gesichtsausdruck, die Körpersprache und ganze Körperteile verändern. Der Charakter kann dann in verschiedene Settings gesetzt werden und alle möglichen Aktivitäten und Arbeitsschritte demonstrieren. Die Kleider und der Bildstil lassen sich selbstverständlich gemäss Corporate Identity definieren. Zeit- und budgetaufwändige Shootings fallen weg. Die Charaktere können reproduziert und so auf der ganzen Welt eingesetzt werden. Das ist zugleich etwas furchteinflössend aber auch sehr attraktiv für die Werbung und Unternehmenskommunikation.

Es lassen sich also realistische Personas erstellen, die vom Herstellungsaufwand dem Realbild mit Menschen überlegen sind. Gilt also Man vs Machine oder reicht „menschlich aussehen“ noch nicht, um als Mensch wahrgenommen zu werden? Die Zukunft wird es zeigen.

Man vs Machine

Wir erinnern uns zurück an mein Projekt mit dem Gletscherfotografen Jürg Kaufmann: https://www.digezz.ch/fotografieren-gegen-schmelzende-gletscher/

Seit letztem Sommer tauschen wir uns regelmässig zu Themen rund um Fotografie, Marketing und Kommunikation aus. Als Unternehmensfotograf besteht seine Arbeit unter anderem aus der Produktion hochwertiger Bilderwelten für renommierte Firmen. Dieser Bereich ist nun unter direktem Beschuss der generativen KI. Viele Unternehmen setzen die künstlichen Bilder heute schon an diversen Orten ein und ersetzen ihre Fotografen. Manche Firmen bauen ganze Taskforces auf, die sich nur mit der Produktion synthetischer Bilder befassen.

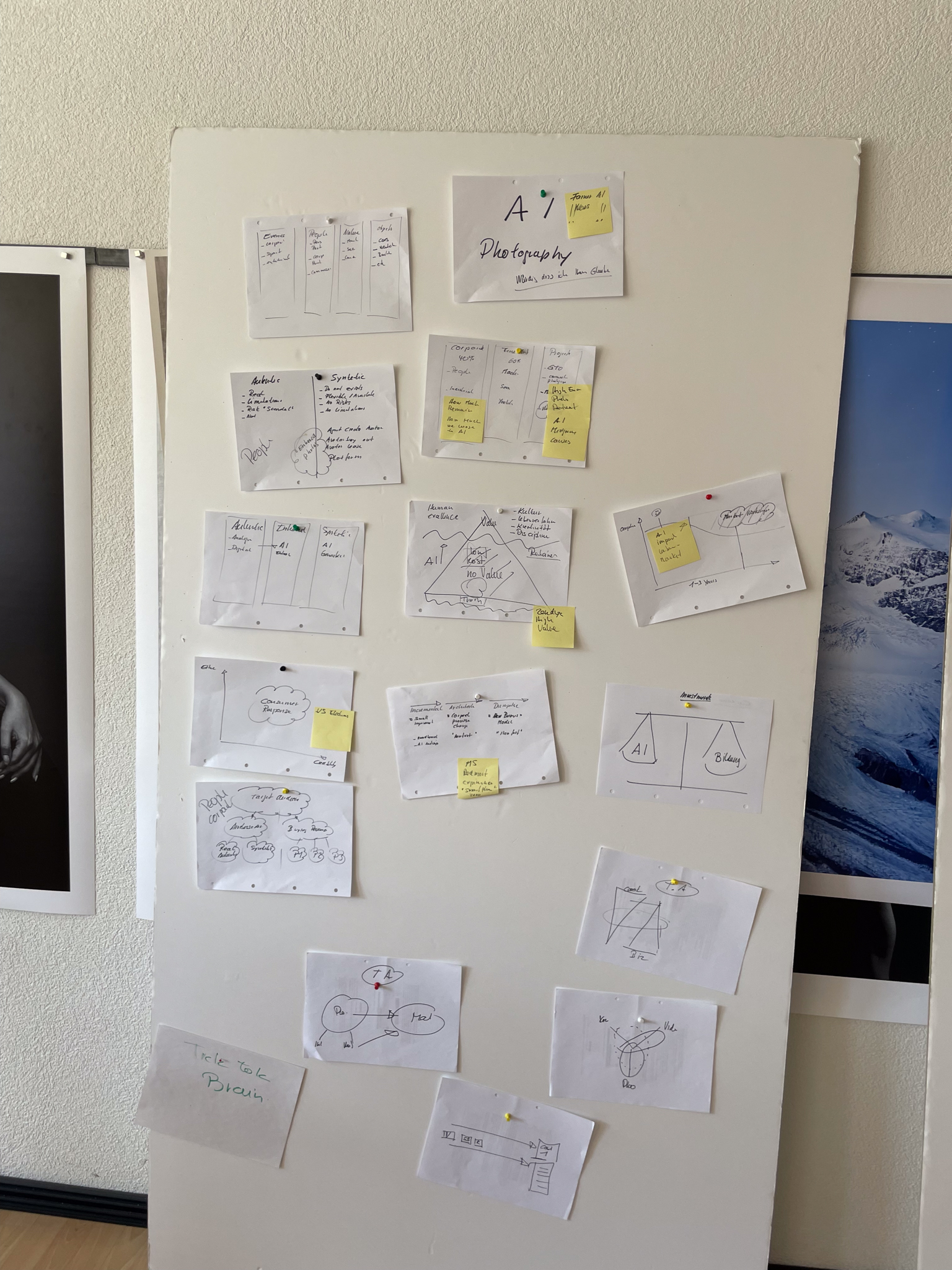

In seinem Studio in Zürich zeigte mir Jürg seine Gedanken auf. Aus seiner Sicht wird es drei Arten von Bildern geben:

- Authentic Images – Echte Bilder aus echten Kameras mit echten Menschen, nicht oder kaum bearbeitet.

- Enhanced Images – Echte Bilder, die mithilfe von KI, beispielsweise in Lightroom oder Photoshop, angepasst wurden.

- Synthetic Images – Künstliche Bilder, die mit der generativen AI generiert wurde, der Mensch existiert nicht.

https://www.juergkaufmann.com/news/drei-kategorien-von-bildern

Jürg hat sich diverse Male mit einem internationalen CMO ausgetauscht. Sie kommen zum Schluss: KI-Bild hat in gewissen Bereichen der Corporate Communications grosses Potential als langfristige und seriöse Alternative zu Echtbild. Aber nur, wenn dieses authentisch ist.

Doch was bedeutet Authentizität? Gemäss Duden: echt; den Tatsachen entsprechend und daher glaubwürdig. Wie lässt sich das in der Realität umsetzen? Und wird Authentizität im Realbild überhaupt heute schon gelebt?

Szenenwechsel.

Ein Unternehmen veranstaltet ein Fotoshooting, um eine neue Bilderwelt für ihre Kommunikation zu gestalten. Um die Persönlichkeitsrechte der Mitarbeitenden zu schützen, werden Models angestellt. Diese übertragen via Release Vertrag die Bildrechte an das Unternehmen. Die Models werden von der Firma eingekleidet und in verschiedenen Bereichen des Unternehmens porträtiert. Wenn der Zuschauer das fertige Bild sieht, meint er, dass das Model tatsächlich bei der Firma arbeitet.

Doch das entspricht nicht den Tatsachen und ist daher per Definition nicht authentisch. Aber spielt das überhaupt eine Rolle? Nimmt der Rezipient die Werbung als authentisch war, solange das Model sympathisch ist und zum Unternehmen passt?

In meinen Augen wird Authentizität zentraler sein als je zuvor. Es geht darum, Vertrauen zu schaffen und eine standhafte Verbindung zum Publikum aufzubauen. Sei es durch KI-Bilder oder echte Models – wichtig ist, dass die Darstellung realistisch und überzeugend ist und zum Markenbild des Unternehmens passt. Nur so kann Corporate Communication nachhaltig und wirkungsvoll gestaltet werden.

Gerade im Videobereich sehe ich aber, dass die Tools noch einen recht weiten Weg vor sich haben. Animationen von natürlichen Menschenbewegungen sind Stand heute noch kaum möglich. Bewegungen des Hintergrunds, Vertigo Zooms und ähnliches sind aktuell realistisch. Als kleine Demonstration habe ich ein Spec Ad des bekannten Marlboro Man erstellt. Die Tonspur habe ich dabei vom Originalvideo übernommen.

Ich werde die Entwicklung der KI-Tools weiter verfolgen und bin gespannt, was noch kommt.

Spec Ad: Marlboro Man

Spec Trailer: Prison Break

(eli)

Die Auseinandersetzung mit den KI Tools hat bei mir mit einer gewissen Skepsis begonnen. Als angehender Fotograf stellte ich mir die Frage, ob mich diese Software wirklich eines Tages ablösen könnte. Ich ging voll ins »Rabbit-Hole», habe YouTube-Videos am Laufband gesuchtet und unzählige Stunden in Midjourney verbracht. Nachdem man den Prompt geschrieben und abgeschickt hat, wartet man meist rund 20 bis 30 Sekunden: dann sieht man das Ergebnis. Auch wenn man viele Variablen kontrollieren kann, eine gewisse Portion Glück ist immer mit dabei. Frustration und Euphorie sind teilweise nah beieinander. Geduld und strukturiertes Prompting haben sich bei mir als einen Weg zum Ziel erwiesen.